فایل Robots.txt چیست و چگونه یک فایل Robots بسازیم؟

برای هر وب سایتی راهنمای ربات موتورهای جستجو اهمیت دارد؛ زیرا با وجود آنها است که سایت شما ایندکس خواهد شد. فایل robots.txt از نظر سئو تاثیر زیادی در ایندکس شدن سایت شما خواهد داشت. ایندکس شدن صفحات گوگل، عاملی برای رتبه گرفتن صفحههای سایت شما است و بدون ایندکس شدن، صفحات سایت نمیتوانند رتبه ای دریافت کنند.

پس از اینکه سایتتان را طراحی کردید، نیاز است که به رباتهای گوگل و سایر موتورهای جستجو اعلام کنید که کدام صفحه از سایت شما را کرال (crawl) کنند و کدام صفحه را نکنند. از همین رو فایل robots.txt را میسازیم. برای تنظیم فایل robots.txt پنج دستور مهم وجود دارد که در این مقاله به بررسی آنها و نحوه ساخت، بهینه سازی و معرفی این فایل خواهیم پرداخت؛ پس در ادامه این مقاله از افراک همراه ما باشید.

همه چیز درباره فایل Robots.txt

وبمستران باید خودشان فایل robots.txt را بسازند. این فایل به رباتهای موتورهای جستجو دستور میدهد که کدام صفحات وب را خزش کرده و کدام را نباید خزش کنند. طبق پروتکل REP استانداردهایی برای ساماندهی وضعیت خزیدن توسط رباتها و ایندکس کردن آنها و همچنین دسترسی به صفحات وب مشخص شده است. البته فایل robots.txt و لینکهای فالو و نوفالو هم جزو این پروتکلها هستند.

متا تگ Robots

همه افراد به ایندکس شدن سایت خود در گوگل اهمیت نشان میدهند و باید بدانند که اگر صفحات ایندکس شده زیاد باشند اما صفحات دارای رتبه بالا کم باشند، اعتبار دامنه کاهش پیدا میکند. هرچه اعتبار دامنه کم باشد رتبه گرفتن برای سایت هم سخت خواهد بود.

متا تگ robots در صفحههایی مانند صفحههای جستجوی سایت مهم است؛ به دلیل اینکه پل ارتباطی میان صفحات سایت به حساب میآید. توجه کنید برای کاربری که از گوگل به سایت منتقل میشود، این صفحه اهمیتی ندارد و همچنین افراد نمیخواهند که از گوگل به صفحه جستجوی دیگری منتقل شوند.

برای اینکه افراد از ایندکس شدن صفحاتی از سایت جلوگیری کنند، متا تگ Robots ایجاد شده است. کاربرد این متا تگ این است که با رسیدن ربات جستجو به آن ربات با دیدن متا تگ، به صورت کلی صفحه را نادیده میگیرد و به سراغ صفحات دیگری میرود.

مطلب مرتبط: روش های بهبود رتبه سایت در گوگل

نحوه کار فایل robots.txt

از آنجایی که رباتها لینکها را دنبال میکنند، بنابراین اگر از سایتی به سایت دیگر لینک داده شود، رباتها آن لینک را دنبال کرده و به سایت دیگری راه پیدا میکنند. اما قبل از اینکه در آن سایت جدید بخزند، فایل robots.txt را بررسی میکنند. اگر این فایل در سایت مورد نظر موجود باشد، از اطلاعات آن پیروی میکنند؛ در غیر این صورت تمام صفحات سایت را میخزند.

دستورات قابل پشتیبانی در فایل robots.txt

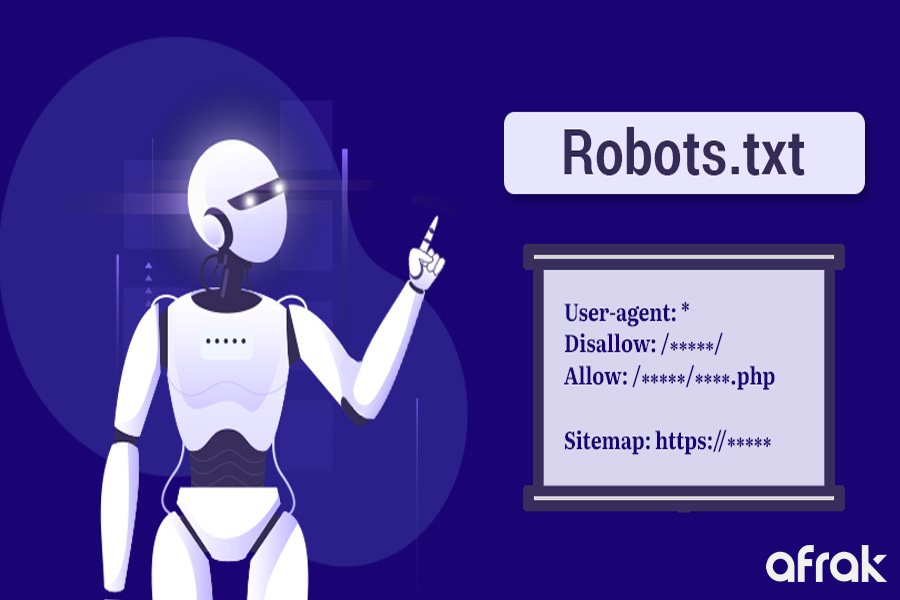

در حالت کلی پنج دستور مهم در فایل robots.txt وجود دارد که شامل موارد زیر میشوند:

دستور user-agent

دستور user-agent نوع رباتی که باید از دستورات بعدی پیروی کند را تعیین میکند. به عنوان مثال اگر میخواهید برای رباتهای گوگل دستور صادر کنید، نام رباتهای گوگل را هم خواهد نوشت. اما گر دستور برای همه رباتها است، باید در مقابل user-agent از علامت * استفاده کنید.

نکته: قابل ذکر است که این دستور نمیتواند به تنهایی، خودش یک دستور کامل باشد؛ پس باید در کنار دستورهای بعدی که در ادامه خواهیم گفت استفاده شود.

دستور disallow

این دستور به معنای اجازه ندادن است؛ پس صفحاتی را که ربات نباید کرول کند را باید در مقابل آن بنویسید. نکته مهمی که وجود دارد این است که روت دامین نباید نوشته شود و فقط باید بعد از اسلش را بنویسید. علاوه بر این، اگر قصد دارید چند صفحه را disallow کنید، باید از چند دستور disallow استفاده نمایید. مانند دستورهای بخش بعدی:

User-agent: *

Disallow: /products/content/

Disallow: /local/enterprise/confirm

Disallow: /researchtools/ose/

Disallow: /page-strength/*

Disallow: /thumbs/*

دستور allow

دستور allow به معنای اجازه دادن است؛ این دستور به رباتهای مشخص شده اجازه میدهد که صفحات نوشته شده در مقابل این دستور بخزند. نحوه استفاده از این دستور دقیقاً مانند دستور disallow است. توجه کنید که نوشتن این دستور واجب نیست؛ به دلیل اینکه رباتها به صورت پیش فرض تمام صفحات سایت را میخزند.

دستور crawl-delay

این دستور میتواند بر سرعت لود صفحههای سایت تاثیر بگذارد. بنابراین سرعت سایت شما به دلیل ورود تعداد زیاد خزندهها کاهش پیدا نمیکند. شما میتوانید در مقابل این دستور هر عددی را بنویسید؛ این اعداد نشان دهنده این است که رباتهای مشخص شده چقدر باید صبر کنند تا سایت را بخزند. البته این دستور برای رباتهای گوگل تاثیری ندارد.

دستور sitemap

استفاده از این دستور نیز راحت است. شما باید در مقابل این دستور آدرس سایت مپ را وارد کنید. این سایت نیازی به دستور user-agent ندارد.

یک فایل Robots.txt باید چه مشخصاتی داشته باشد؟

به طور معمول در این فایل اگر سایتتان وردپرسی باشد، صفحههای /wp-admin/ و /readme.html/ حاوی اطلاعات نسخه وردپرس شما هستند. همچنین تمام افزونههای سایتتان باید disallow شوند. آدرس سایت مپ را هم در این فایل تعریف میکنند تا خزندههای گوگل جایگاه صفحههای مختلف سایت را بیابند. البته شما میتوانید با توجه به نیازهای خود، از هر فایلی به دلخواه خودتان در disallow استفاده کنید.

حتما بخوانید: مهم ترین فاکتورهای رتبه بندی گوگل

کاربرد فایل robots.txt

این فایل میتواند خیلی کاربردی باشد؛ برخی از کاربردهای آن عبارتند از:

- میتوانید برای رباتها یک زمان تاخیر در خزیدن تعریف کنید؛ با این روش دیگر وقتی سایت شما شلوغ شد سرعت آن پایین نخواهد آمد و به نوعی ترافیک را مدیریت خواهد کرد.

- اگر محتوای تکراری در سایت داشتید، میتوانید یکی از صفحات را disallow کنید.

- میتوانید بخشی از سایت مانند صفحه عقد قراردادها را در دسترس همه افراد قرار ندهید.

- همچنین با این فایل میتوانید نقشه سایت را برای رباتهای گوگل توسط دستور allow مشخص نمایید.

- اجازه ایندکس فایلهای PDF یا تصاویر را به رباتها ندهید.

چطور فایل robots.txt بسازیم؟

برای اینکه فایل robots.txt بسازید، باید مراحل زیر را دنبال کنید:

- به صفحه اصلی هاست خود در سی پنل و یا دایرکت ادمین بروید.

- روی file manager کلیک نمایید.

- سپس وارد پوشه public_html شوید.

- بعد از اینکه وارد پوشه شدید، فایل جدیدی به نام robots.txt ایجاد کنید.

- سپس فایل را (با دو بار کلیک) ذخیره کنید و دستورات مدنظر خود را در آن وارد کنید.

- بعد از ذخیره تغییرات، فایل را جایگزین فایل قبلی بکنید.

نکته مهمی که باید در تمامی مراحل به آن توجه کنید این است که فایل robots.txt به کوچک و بزرگ بودن حروف حساس است و حتی نام خود فایل را هم باید با حروف کوچک بنویسید.

فایل robots.txt چه تاثیری در سئو دارد؟

از نظر سئو باید چندین مورد رعایت شود که عبارتند از:

- فایلهای که در disallow قرار دارند، در حالت کلی خزیده نمیشوند. همچنین حتی لینکهای داخل این فایلها به نوفالو تبدیل میشوند؛ پس اگر قصد دارید لینکهای داخل صفحه فالو باشند، از روش دیگری به غیر از disallow استفاده کنید.

- باید بدانید که استفاده از دستور disallow برای عدم نشان دادن اطلاعاتی مثل اطلاعات خصوصی افراد کاری بی فایده است. چرا که ممکن است شما از صفحات دیگر سایت به این صفحه لینک داده باشید و خزندهها یا رباتها توسط آن لینکها به صفحه ذکر شده رسیده باشند و آن را ایندکس کنند.

- به طور معمول اطلاعات فایل robots.txt در موتورهای جستجوی گوگل، یک روز در کش ذخیره و نگهداری میشوند. پس اگر محتوای این فایل را تغییر بدهید تا موتورهای جستجو از این تغییرات زودتر اطلاع داشته باشند، نیاز است که فایل را دوباره در کنسول گوگل قرار بدهید.

چک کردن وجود فایل robots.txt در یک سایت

برای اینکه در یک سایت بررسی کنید که فایل robots.txt وجود دارد یا نه، باید در انتهای ریشه دامین اصلی سایت مورد نظرتان اسلش بگذارید و سپس عبارت robots.txt را بنویسید. با این دستور محتویات فایل را مشاهده خواهید کرد و در صورت وجود نداشتن فایل با ارور 404 رو به رو خواهید شد.

سخن پایانی

ساخت فایل robots.txt از مبحثهای مهم سئو تکنیکال است که باعث میشود توسط دستورهای مختلف به رباتها بگوییم که کدام فایل را خزش کرده و کدام را نکنند. در این مقاله به بررسی فایل robots.txt، تاثیر در سئو، نحوه ساخت آن و کاربردهایش صحبت کردیم. امید است که بتوانید از مطالب این مقاله بهره مند شوید.

سوالات متداول

فایل robots.txt متنی است که برای بهبود سئو سایت استفاده میشود. این فایل دستورهایی دارد که مشخص میکنند صفحه ای میتواند ایندکس شود یا نه.

برای مدیریت دسترسی موتورهای جستجوی گوگل، بهینه سازی سایت، مدیریت لینکها و آدرسها و به حداکثر رساندن بودجه خزش میتوانیم از فایل robots.txt استفاده کنیم.

برای اینکه از ایندکس شدن مقالات خاص خود در سایت توسط رباتهای مختلف جلوگیری کنید، کافی است از متا تگ نو ایندکس استفاده کنید.

نظر کاربران

نظرات و سوالات خود را با ما مطرح کنید